SEO

SEOТехнический аудит сайта

За хорошей работой сайта, за красивыми картинками, привлекательными текстами и прочими свистелками всегда стоит скучная техническая часть, без которой никуда. Ошибки в технической работе сайта, как и любые другие, негативно сказываются на всех его коммерческих показателях, поэтому технический аудит проводить обязательно. В этом материале мы приведем чек-лист технического аудита сайта: на что смотреть, как оценивать и как исправлять.

И если может показаться, что технический аудит — это нечто сложное и понятное не всем, то спешим успокоить. Его вполне можно сделать самостоятельно. Вот, что должно в него входить.

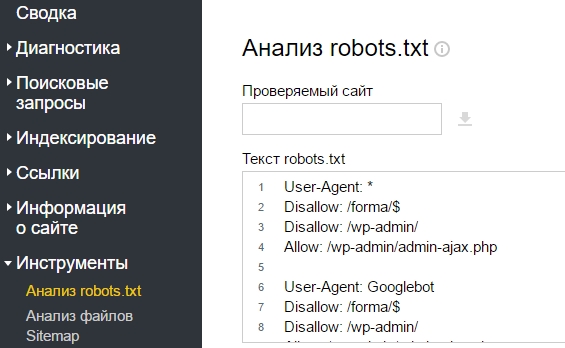

Проверка файла robots.txt

Файл robots.txt обязательно должен присутствовать на каждом сайте. Он служит для того, чтобы указывать поисковику, какие страницы нужно индексировать, а какие нет. О том, как правильно составить robots.txt мы писали в этой статье: проверьте, скрыты ли от индексации технические страницы вроде админки, есть ли у поисковика доступ к скриптам сайта и файлам CSS.

Корректно ли настроен robots.txt можно посмотреть в Яндекс.Вебмастере.

Sitemap

Проверьте на корректность файл карты сайта. Она нужна, в частности, для того, чтобы ускорить процесс индексации сайта. О том, как создать правильный sitemap можно прочитать здесь.

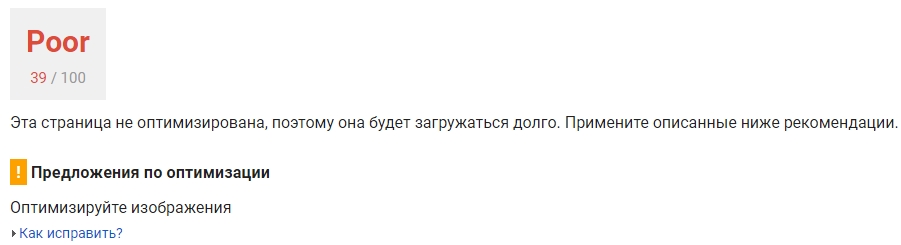

Скорость загрузки сайта

Пользователь становится все более разбалованным, и лишние пять секунд загрузки его могут напрочь отвратить от сайта. Что делать в таком случае? Во-первых, замерить скорость открытия страниц. Для этого можно воспользоваться браузером Google Chrome (F12 — Network — Doc — Time) либо одним из наглядных онлайн-сервисов по оценке скорости работы сайты.

Если скорость загрузки оставляет желать лучшего, есть ряд мероприятий, которые всегда можно провести.

Также проверьте свой хостинг, как быстро он работает, обеспечивает ли он достаточный аптайм сайта.

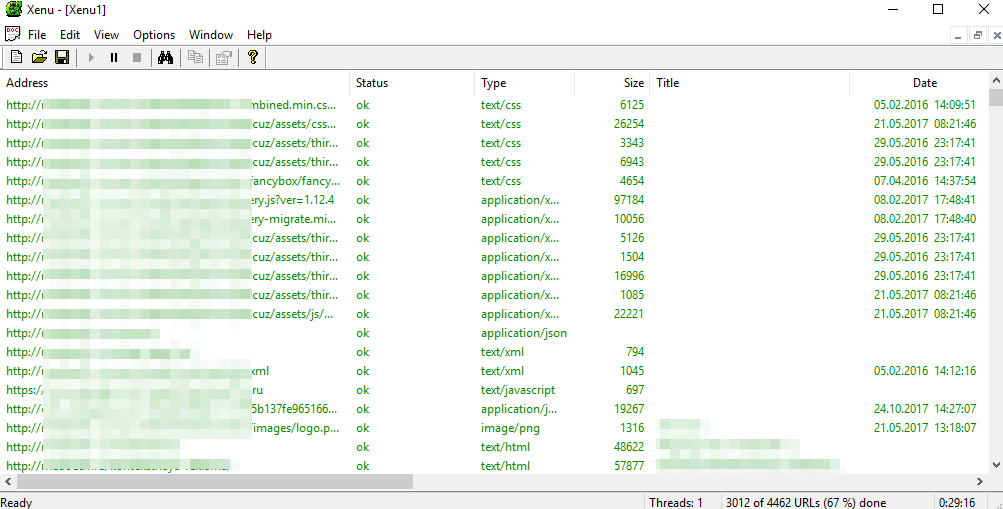

Проверка ссылок

Проверяя URL-ы сайта, нужно уделять внимание следующим моментам:

- не должно быть дублей страниц

- настроены редиректы

- желательно написание ЧПУ (человекопонятных урлов)

- адреса страниц должны быть постоянными

- отсутствие битых ссылок и ошибок 404

Проверку ссылок можно запустить с помощью сервисов Screaming frog SEO spider или Xenu Link Sleuth.

Например, в Xenu Link Sleuth достаточно ввести ссылку на сайт и получить полный отчет (его генерация может занять довольно долгое время, в зависимости от сайта) об ошибках, выявить битые ссылки и исправить найденные ошибки.

Проверка кода сайта

Код сайта может оказывать влияние и на индексацию сайта, и на скорость его загрузки. К ошибкам, требующим исправления, относятся незакрытые теги, сбои в кодировке, скрытые тексты, избыточные комментарии и прочий мусор, подчистив который, можно свой сайт улучшить.

Конечно, вручную сделать это достаточно трудно, поэтому существуют хорошие помощники. Например, сервис validator.w3.org или проверка через Google Search Console.

Эти проверки могут занять достаточное долгое время, особенно, если у вас большой сайт, и им никто не занимался, но в то же время, они и не настолько трудные — все важные вопросы могут просканировать доступные бесплатные сервисы, а вам останется исправить найденные недочеты.

/rating_on.png)